Bamboo is coming

KL Divergence 본문

본 글은 팡요랩 유튜브를 보고 정리한 글입니다.

동영상에서는 PRML(Pattern Recognition & Machien Learning, Bishop)을 참고했다고 합니다.

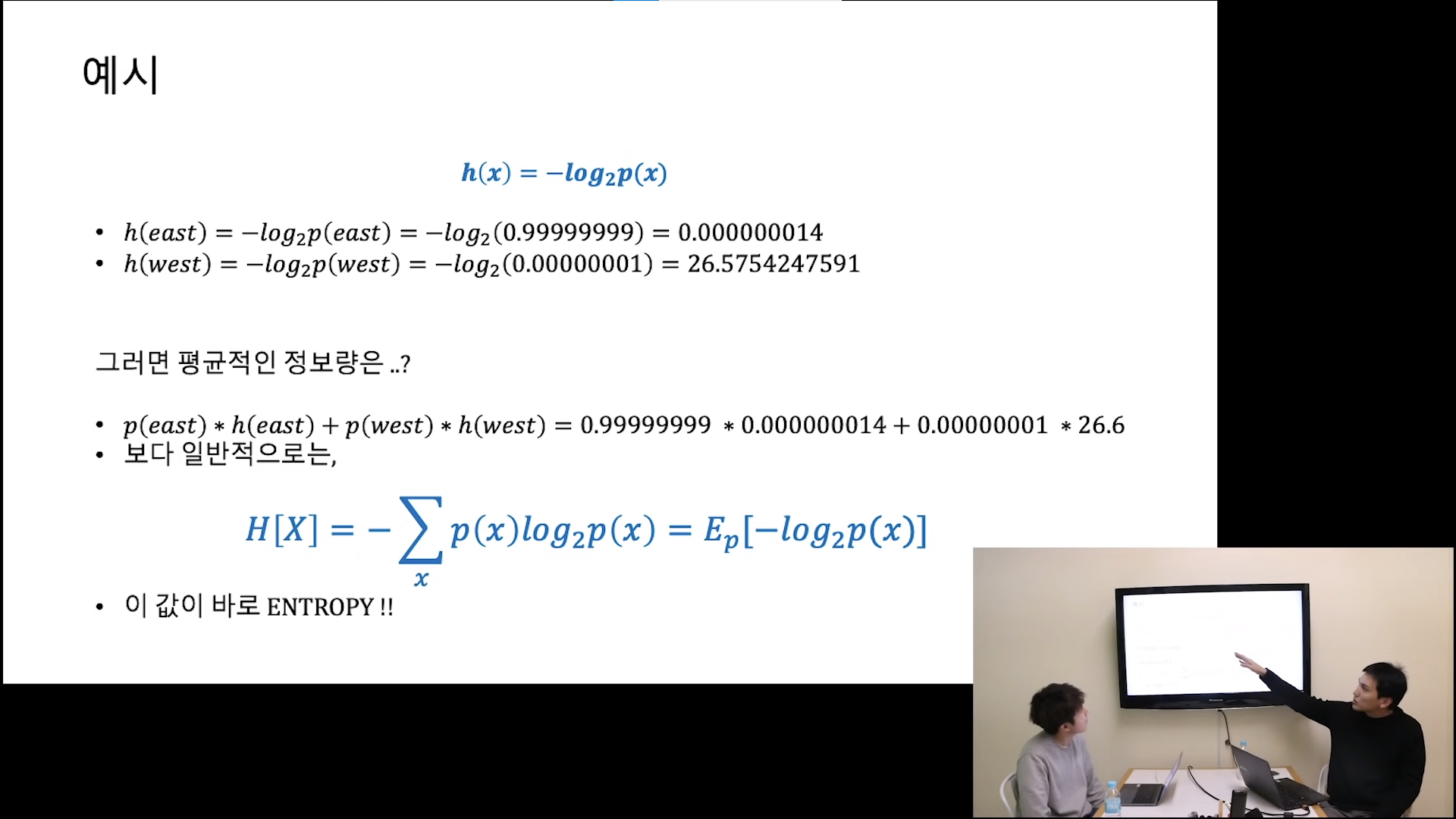

정보량은 깜놀도로 확률 p(x)에 대한 함수이다.

확률과 엔트로피는 시소같은 관계로 monotonic하다라고도 표현한다.

- \(h(x, y) = h(x) + h(y)\)

- 정보량은 사건의 불확실성을 측정하는 것으로, 두 사건이 독립적일 때, 한 사건의 정보량과 다른 사건의 정보량을 합한 것은 두 사건이 동시에 발생했을 때 총 정보량과 같다.

- 독립 사건의 정보량이 서로 추가적인 정보를 제공하기 때문에, 각 사건의 정보량을 단순히 더하면 전체 사건의 정보량이 된다.

- 예시, 두 개의 방의 스위치 상태를 알게 된다고 하면(정보량) 첫 번째, 두 번째 방의 정보량은 각각 1비트이고 두 사건의 정보량을 동시에 알게된다면 각각 독립적인 방이므로 2비트, 그래서 덧셈 연산이 필요하다.

- \(p(x, y) = p(x) * p(y)\)

- 두 사건이 독립적이면, 하나의 사건이 발생할 확률과 다른 사건이 발생할 확률을 곱하여 두 사건이 동시에 발생할 확률을 구할 수 있다.

- 이는 두 사건이 서로 영향을 주지 않으므로, 각 사건의 확률을 단순히 곱하면 된다.

- 예시, 두개의 방의 스위치 상태가 ON일 확률을 구하려고 하면 첫 번째, 두 번째 방의 스위치 확률이 각각 1/2이라고 할 때 두 가지가 동시에 발생될 확률은 곱셈

- \(h = f(p)\) 라고 했을 때, \(h(x,y) = f(p(x,y)) = f(p(x) * p(y)) = h(x)*h(y) = f(p(x))+f(p(y)) \)

- 이 식에 따르면 \(f\)는곱셈이 덧셈이 되는 연산임을 알 수 있다.

- 곱셈이 덧셈이 되는 연산 가운데 우리가 아는 연산은 \(log\)함수.

Entropy

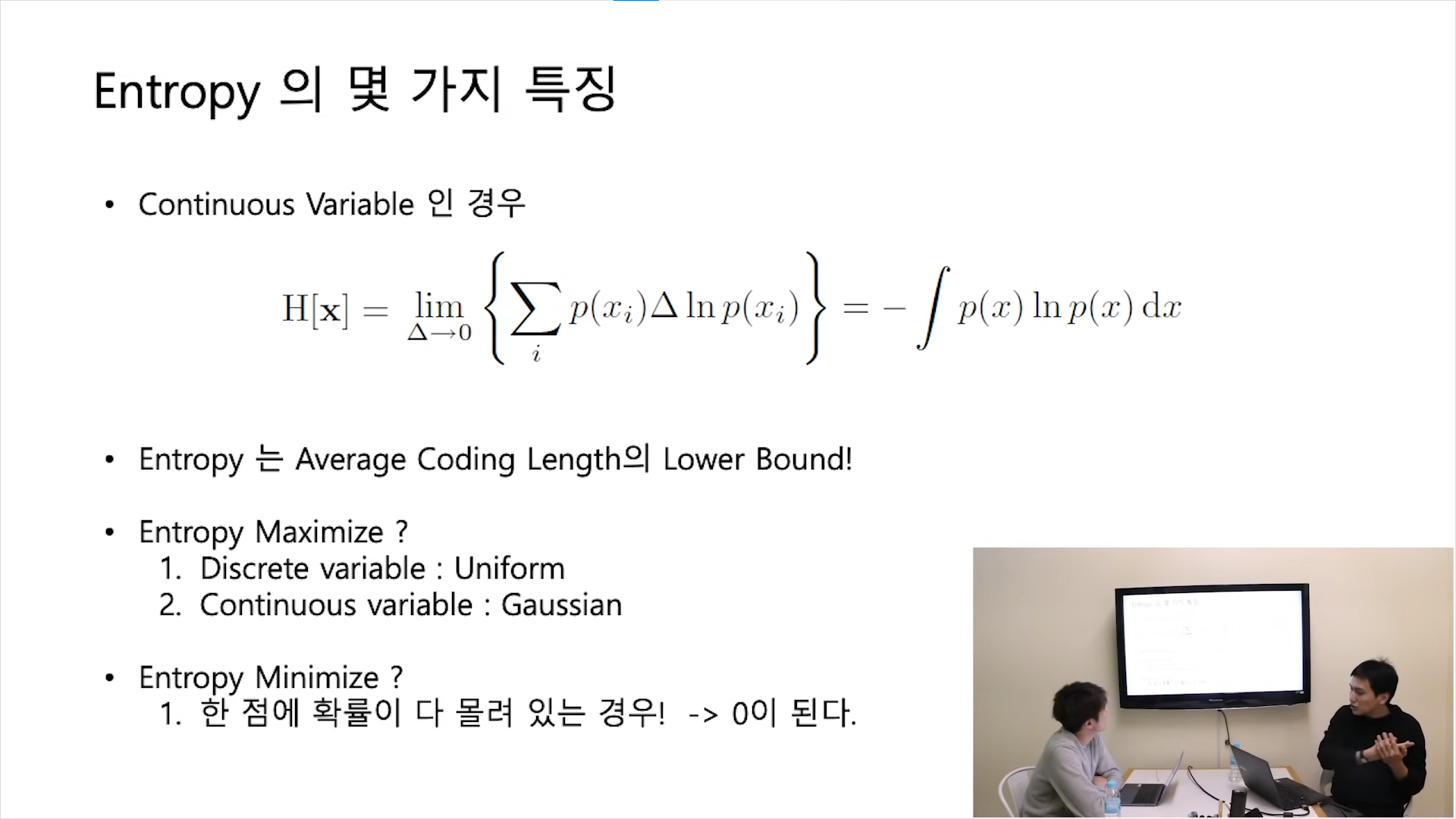

- 엔트로피는 평균 코드 길이의 Lower bound = 최대 압축 코드 길이

- 불균등 주사위가 엔트로피가 더 작고, 균등 주사위가 엔트로피가 더 크다.

- 엔트로피가 최대가 될 경우

- 연속되지 않은 변수의 경우 -> 균등한 확률일 때 엔트로피가 최대

- 연속되는 변수의 경우 -> 가우시안 확률일 때 엔트로피가 최대

- 엔트로피가 최소가 될 경우

- 한 점에 확률이 다 몰려 있는 경우 새로울 게 없으므로 0이 된다.

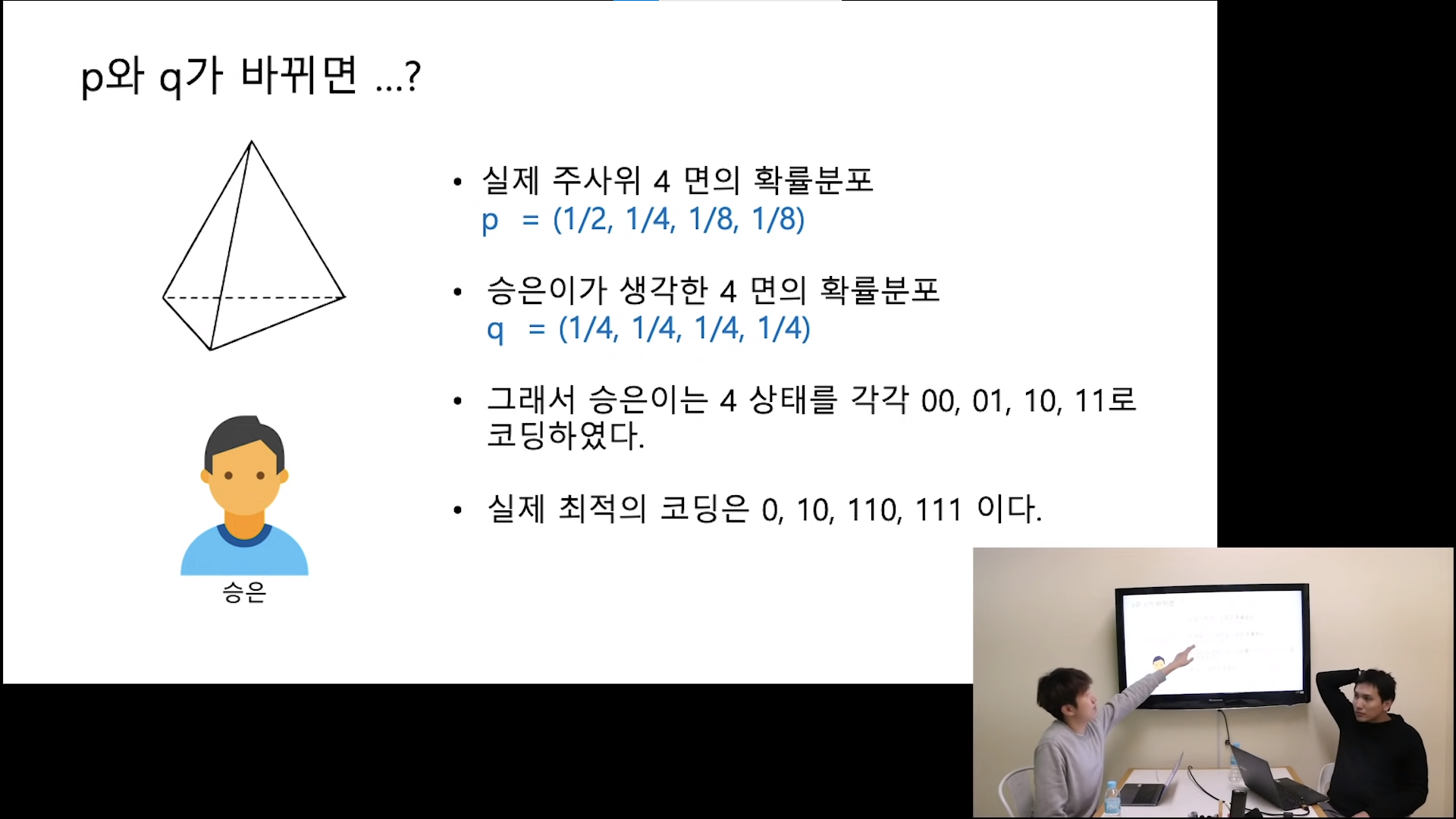

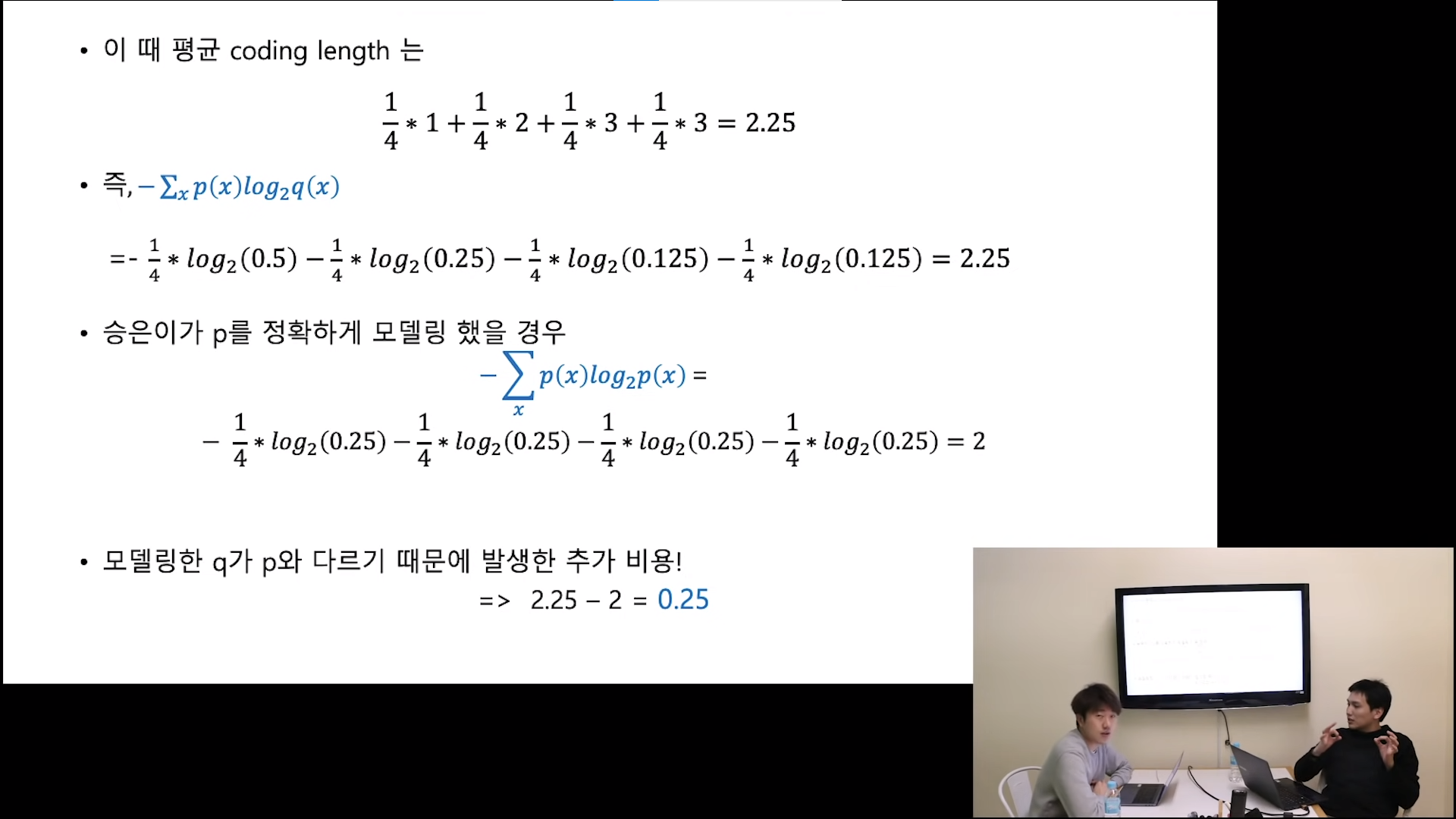

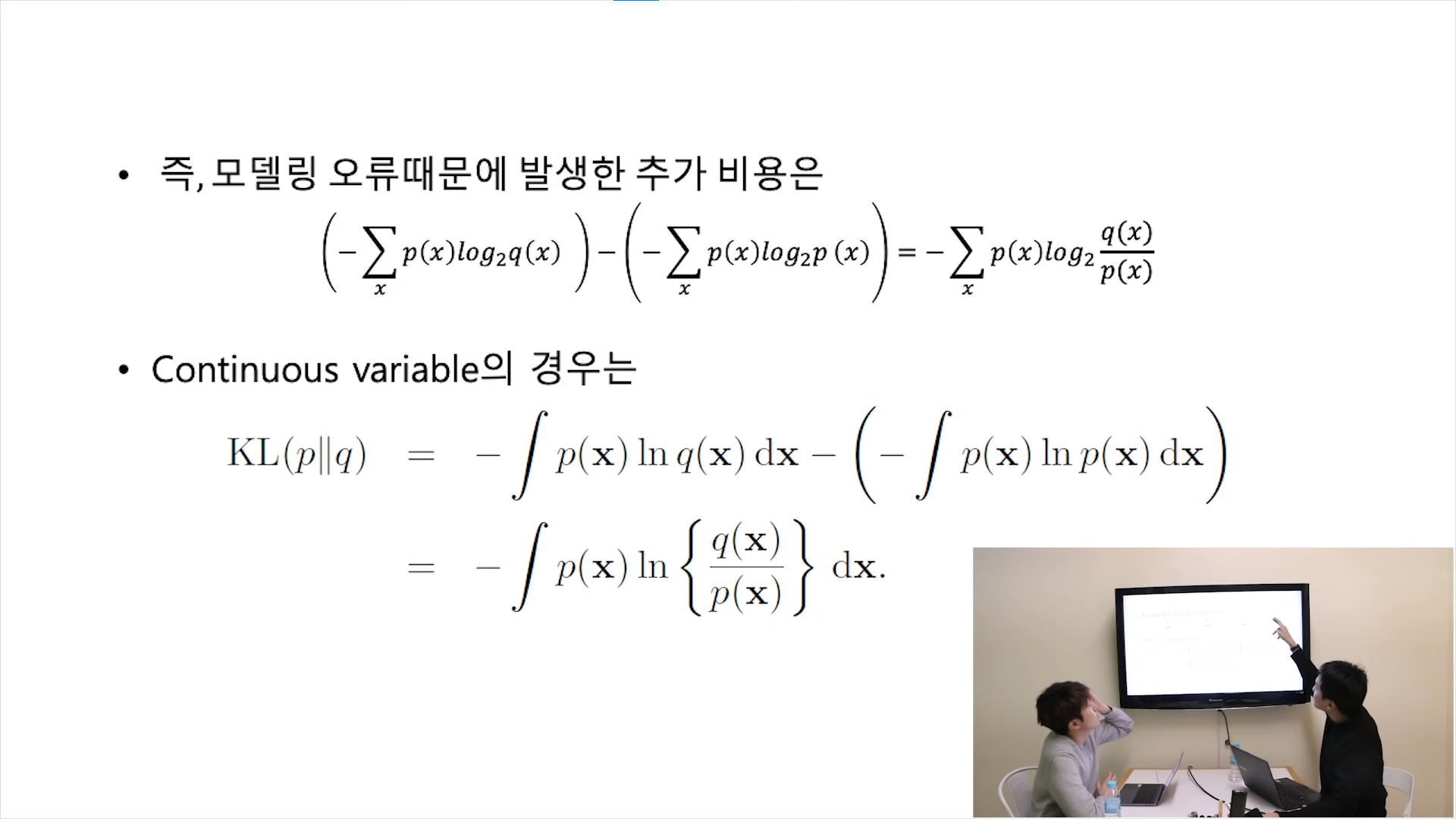

KL Divergence

- KL Divergence는 모델링의 오차가 있을 때 입는 손해량 -> Loss 함수로 KL divergence가 많이 쓰이는 이유

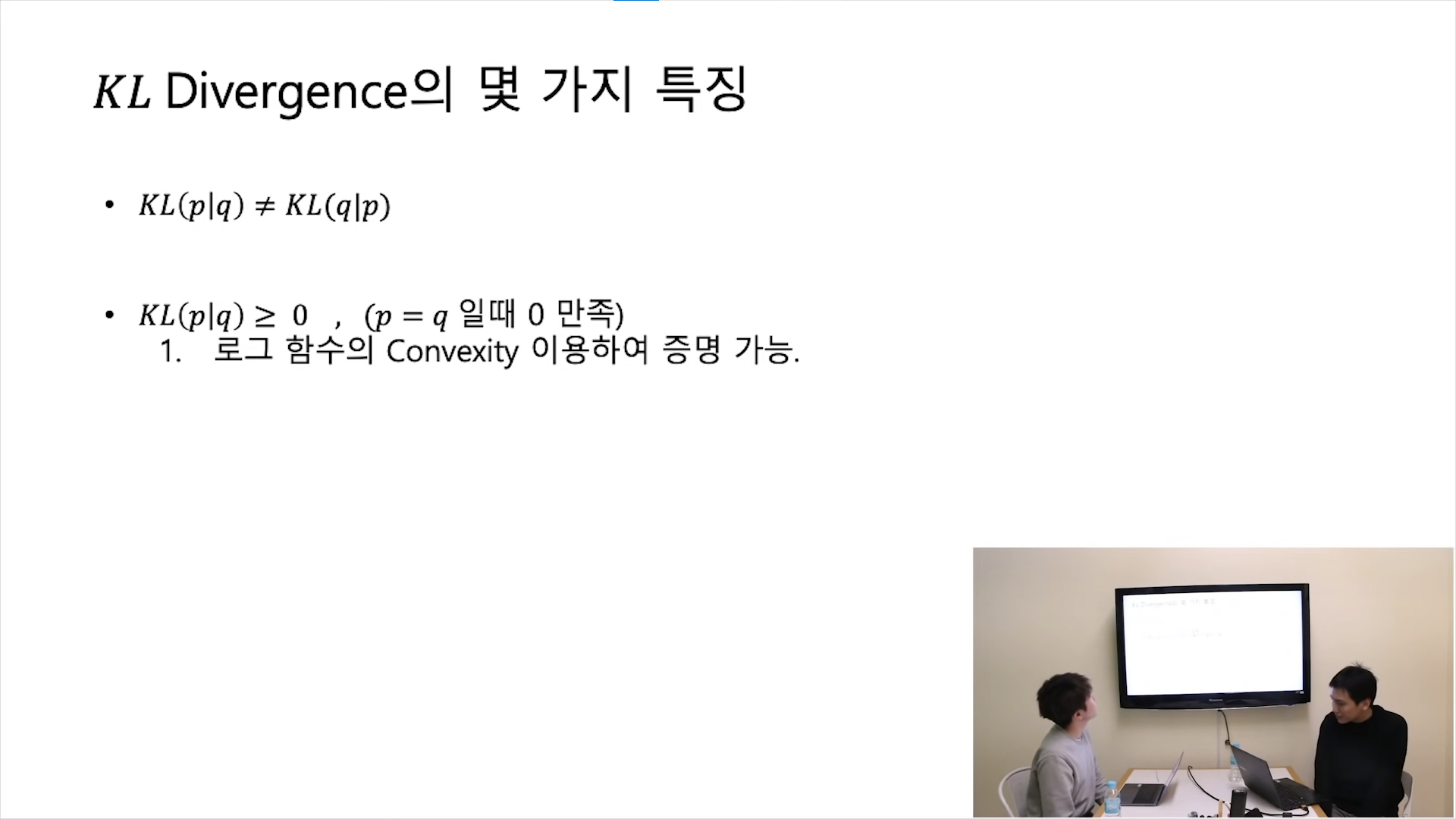

- \(KL(p||q) \neq KL(q||p) \)

- \( KL(p||q) \geq 0 \)

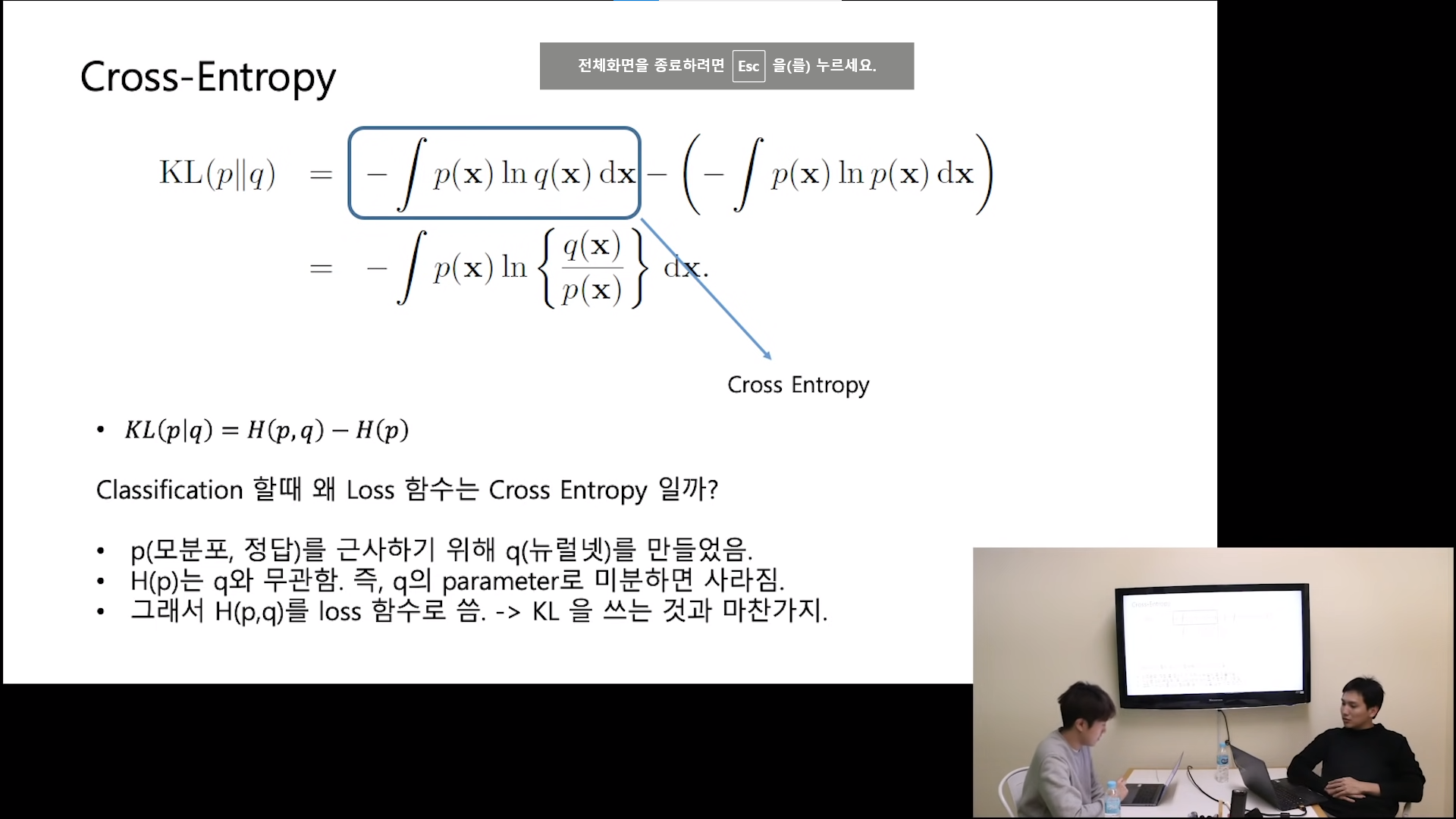

Cross-Entropy

- Cross Entropy가 오차 함수로 많이 쓰이는 이유

- 우리의 관심 영역은 q, q로 미분하면 p항이 사라짐. 그래서 결국 q항만 남아 q항 자체가 cross entropy가 됨

https://youtu.be/Dc0PQlNQhGY?si=WjhoULxCX0Q7z67X

https://norman3.github.io/prml/

PRML

Sep 27, 2016 요즘 시간이 없어서 업데이트를 자주 못합니다. 그래도 생각날때마다 조금씩 내용을 업데이트하고는 있습니다. 앞으로도 계속 이런 식으로 진행될 것 같습니다. Mar 30, 2016 PRML Study 페

norman3.github.io

'인공지능 개념' 카테고리의 다른 글

| Convolution (신호및시스템) (0) | 2024.03.14 |

|---|---|

| VAE (0) | 2024.02.20 |

| Deep Image Prior (0) | 2024.01.30 |

| in-context learning (0) | 2024.01.27 |

| distributed-representation (0) | 2024.01.19 |

Comments